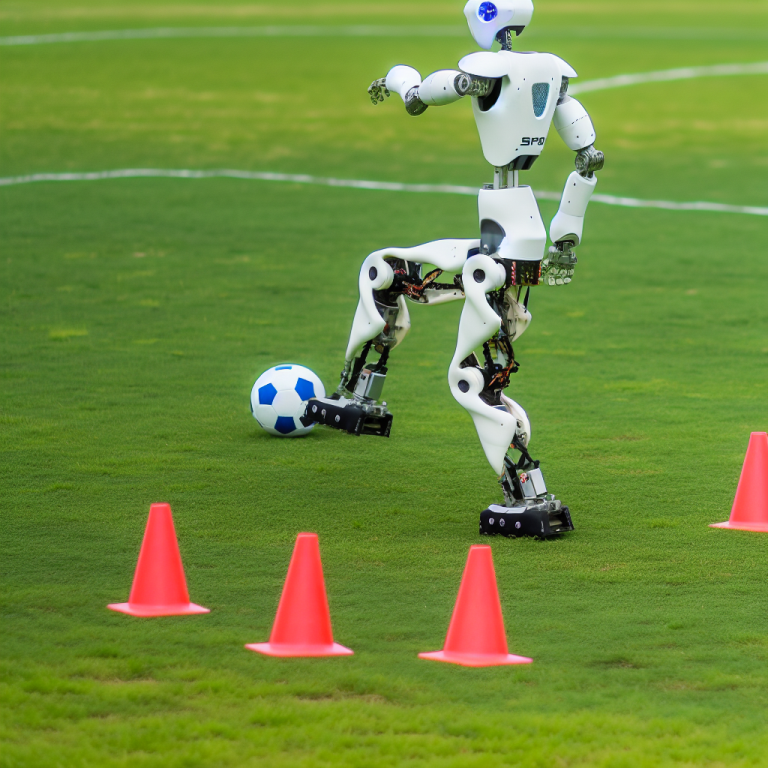

Un estudio reciente llevado a cabo por Haarnoja et al. exploró el mundo del aprendizaje profundo por refuerzo para mejorar las habilidades motoras de robots bipedales a través de un marco de fútbol humanoide. Los métodos de control tradicionales han tenido dificultades para adaptarse a tareas específicas en el mundo real, lo que dificulta el desarrollo de habilidades motoras sólidas en los robots. Los investigadores utilizaron con éxito el aprendizaje profundo por refuerzo para crear una plataforma para controlar robots humanoides y establecer partidos de fútbol uno a uno. Los robots mostraron comportamientos emergentes como la capacidad de recuperarse de caídas y participaron en maniobras tácticas como defender el balón contra un oponente. Este marco permitió que los robots se movieran más rápido en comparación con un controlador base programado, demostrando su potencial para interacciones más complejas que involucran múltiples robots.

El objetivo del estudio era explorar si el aprendizaje profundo por refuerzo podría producir capacidades de movimiento avanzadas y seguras para un robot humanoide en miniatura rentable que pudiera integrarse sin problemas en estrategias de comportamiento elaboradas. Al utilizar el aprendizaje profundo por refuerzo, los investigadores entrenaron a un robot humanoide para participar en un juego de fútbol uno a uno simplificado. El resultado final fue un agente con habilidades de movimiento sólidas y dinámicas, lo que le permitió recuperarse rápidamente de caídas, caminar, girar, golpear y realizar transiciones entre estos movimientos de manera fluida y eficiente. El agente también aprendió a predecir los movimientos del balón y bloquear los tiros del adversario, adaptando sus tácticas a escenarios de juego específicos de una manera que sería impracticable de diseñar manualmente.

El proceso de entrenamiento tuvo lugar en un entorno simulado, y los comportamientos aprendidos se transfirieron sin esfuerzo a robots reales sin adaptación previa. Una combinación estratégica de control de alta frecuencia, aleatorización de la dinámica y perturbaciones durante el entrenamiento facilitaron una transferencia exitosa y de alta calidad. Durante las evaluaciones experimentales, el agente entrenado superó al controlador base programado caminando un 181% más rápido, girando un 302% más rápido, necesitando un 63% menos de tiempo para recuperarse de caídas y pateando un balón un 34% más rápido.

El objetivo continuo de los investigadores en inteligencia artificial y robótica es desarrollar agentes inteligentes con inteligencia incorporada, capaces de actuar con agilidad, destreza y un entendimiento integral de su entorno similar a animales u humanos. Los avances recientes en técnicas basadas en el aprendizaje, en particular el aprendizaje profundo por refuerzo, han acelerado significativamente el progreso hacia este objetivo. Si bien se han abordado eficientemente tareas elaboradas de control motor para personajes simulados y robots físicos, se ha puesto menos énfasis en humanoides y robots bipedales debido a la estabilidad, seguridad, grados de libertad y limitaciones de hardware.

La integración del aprendizaje profundo por refuerzo ha demostrado ser beneficiosa, produciendo metodologías de control más versátiles y eficientes para robots humanoides, facilitando tareas que abarcan agilidad, estabilidad y capacidades motoras integrales más allá de habilidades básicas como caminar, correr y saltar.

En el ámbito deportivo, el fútbol destaca como un dominio que refleja la inteligencia sensoriomotriz humana, mostrando complejidades que plantean desafíos únicos para la robótica. Los investigadores centraron su atención en partidos de fútbol uno a uno simplificados para demostrar el conjunto completo de habilidades de los robots humanoides a través de una estrategia de control sensoriomotor de cuerpo completo que incorpora observaciones de propiocepción y captura de movimiento. El proyecto sienta las bases para continuar investigando en la mejora de la agilidad y habilidades de los robots humanoides, empujando los límites de lo que estas máquinas pueden lograr en entornos físicos.

Fuente: https://www.science.org/doi/10.1126/scirobotics.adi8022